随着人工智能、大数据和云计算等产业发展,对高性能内存需求不断攀升,HBM相对于传统DRAM,具有高带宽、高容量、低功耗和低延迟等优点,更适合ChatGPT等高性能计算场景,迎来快速成长期。

根据Mordor Intelligence预计,2023年全球HBM市场规模为20.4亿美元,2028年有望达到63.2亿美元,CAGR为25.38%;而TrendForce预计2025年HBM全球市场规模将会突破100亿美元。

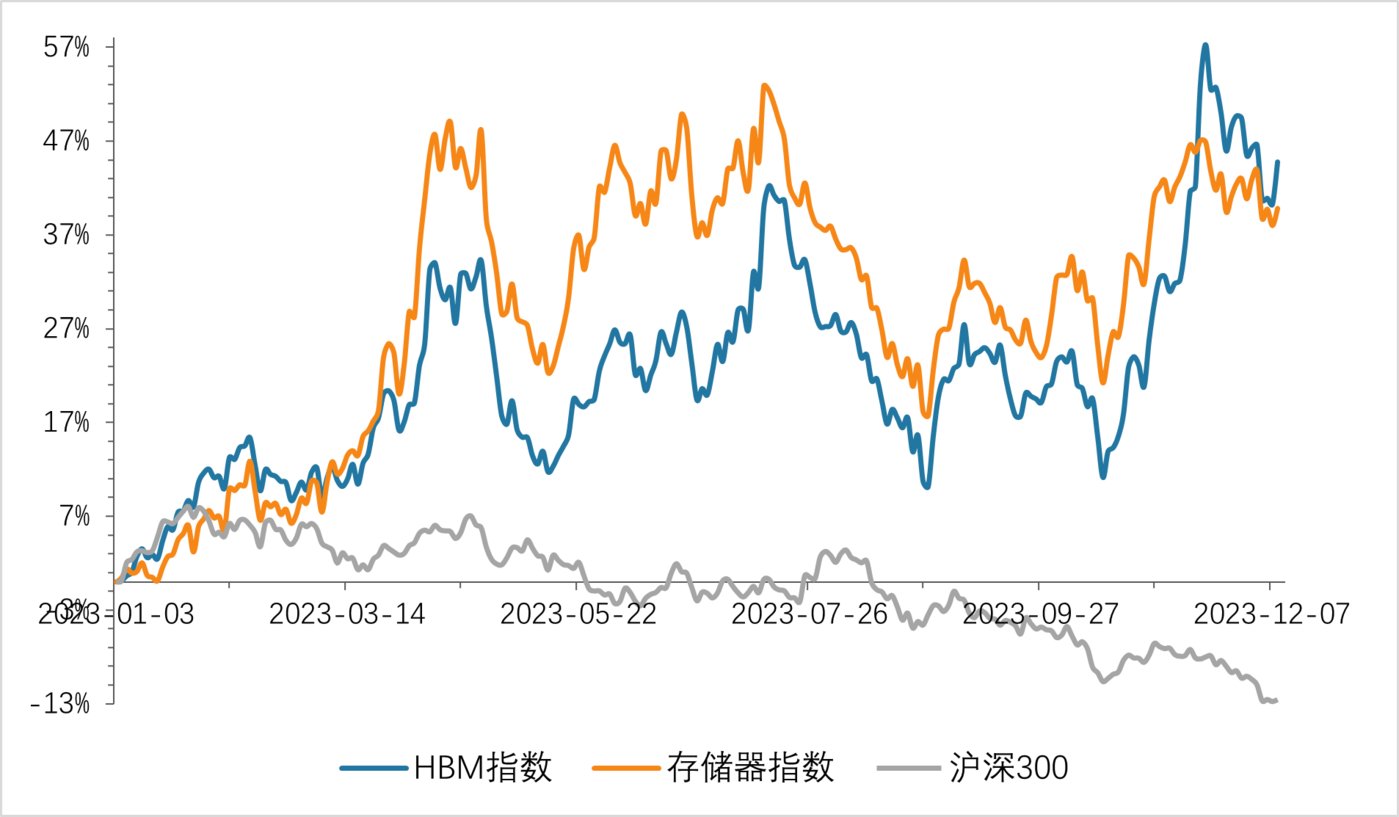

四季度存储芯片市场价格经过前期下跌后出现止跌反弹,存储板块也有所上涨,其中HBM板块上涨幅度较存储板块更大,目前板块较10月中下旬低点上涨33.64%,本文来对HBM产业进行一下分析。

资料来源:wind,钛媒体产业研究部

主要应用于高端GPU,AIGC催生产品需求HBM(High Bandwidth Memory)即高带宽存储,行业标准组织JEDEC(电子工程器件联合委员会)将DRAM分为三类,标准DDR、移动DDR以及图形DDR,其中图形DDR包括GRRD和HBM。

处理器计算能力近年得到大幅增长,但内存性能的提升速度却远远落后,导致内存性能很大程度上限制了处理器性能的发挥,在对数据处理时间大幅延长的同时也大幅提升了能耗,引发“内存墙”的问题。

相比DDR4和DDR5等产品,HBM通过TSV(硅通孔)垂直堆叠多个DRAM,突破了带宽和容量瓶颈,使GPU具有更快并行处理速度,目前主要应用于高端GPU中。

从2014年全球首款HBM产品问世至今,已发展至第四代HBM3,带宽和容量分别从最初128GB/S和1GB提升至819GB/S和24GB,传输速度从1Gbps提高至6.4Gbps。

而SK接下来将要发布的HBM3E与HBM3相比,传输速度将提高25%,由6.4Gbps提高至8Gbps,带宽也提升至1TB/S。

英伟达首款搭载HBM3E的最新一代AI处理器H200预计将于2024年第二季度上市,显存为141GB,带宽为4.8TB/S,与H100相比,容量提升76.25%,带宽提升43.28%。

目前HBM约占整个DRAM市场份额的1.5%,随着AIGC模型对AI服务器需求快速增长,HBM渗透率有望加速提升,根据TrendForce数据,2022年全球AI服务器出货量85.5万台,预计到2026年出货量将达到236.9万台,CAGR为29.02%。

在AIGC模型训练侧,目前AI服务器主要采用中高端GPU,HBM在其中渗透率接近100%;而在推理侧AI服务器GPU目前主要采用中低端,HBM渗透率较低,未来随着AIGC模型逐渐复杂化,中高端GPU占比将会提升,相应的HBM渗透率也将逐步提升。

关于文章完整内容分析,可升级为钛媒体PRO用户阅读全文。